Pourquoi une IA générative consomme-t-elle autant d’énergie ?

- Une requête d’environ 400 tokens sur ChatGPT / GPT-4o mini (modèle à 35 milliards de paramètres) consomme environ 2 Wh [1] d’électricité (ou 2 g de CO2 rejeté) [2], soit plus de 6 fois la consommation d’une recherche Google classique estimée à 0,3 Wh [3]. Pour un modèle moins frugal tel que Meta / Llama 3.1 405B (405 milliards de paramètres) une requête d’environ 400 tokens consomme 55 Wh (équivalent à 55 g de CO2 émis) !

- La création d’une image en haute définition par une IA consomme autant d’énergie que la recharge complète d’un téléphone portable.

- Les centres de données (data centers) liés à l’IA et aux crypto-monnaies ont consommé près de 460 TWh (460×1012 Wh) d’électricité en 2022, soit environ 2% de la production mondiale. De nombreux experts s’accordent à dire que ce pourcentage aura vraisemblablement doublé d’ici 2026 [4].

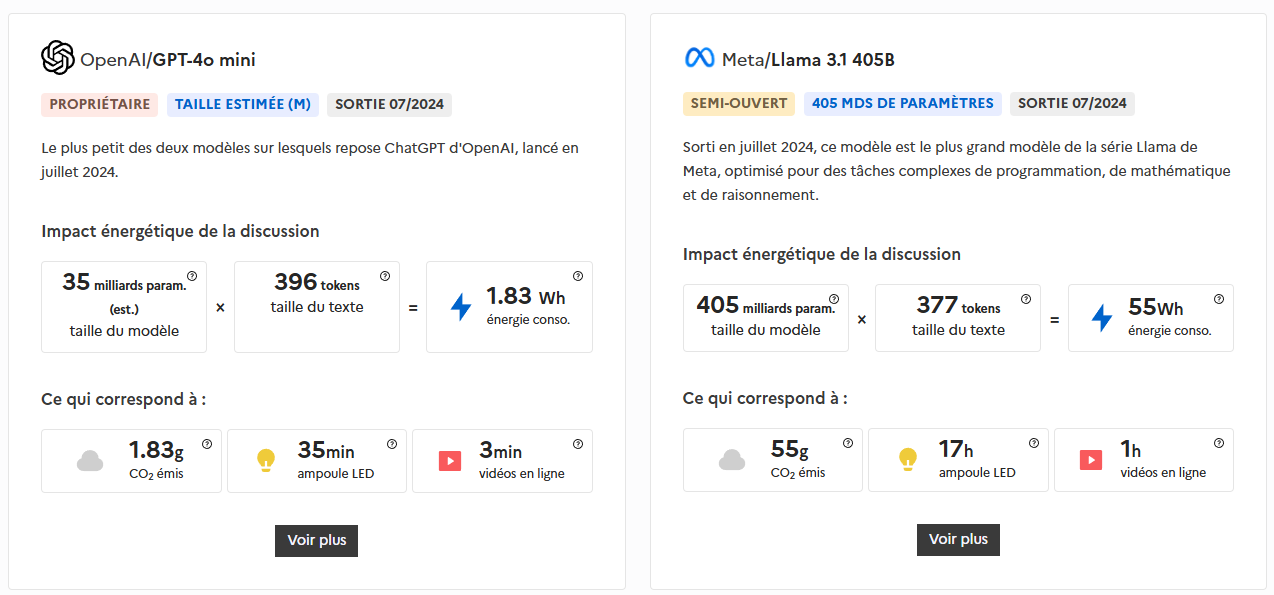

OpenAI/GPT-4o mini

Le plus petit des deux modèles sur lesquels repose ChatGPT d’OpenAI, lancé en juillet 2024.

Impact énergétique de la discussion :

– Taille du modèle : 35 milliards paramètres

– Taille du texte : 396 tokens

– Energie consommée : 1.83 Wh

Ce qui correspond à :

– 1.83 g de CO2 émis

– 35 min de fonctionnement d’une ampoule LED

– 3 min de fonctionnement d’une vidéo en ligne

Meta/Llama 3.1 405B

Sorti en juillet 2024, ce modèle est le plus grand modèle de la série Llama de Meta, optimisé pour des tâches complexes de programmation, de mathématique et de raisonnement.

Impact énergétique de la discussion :

– Taille du modèle : 405 milliards paramètres

– Taille du texte : 377 tokens

– Energie consommée : 55 Wh

Ce qui correspond à :

– 55 g de CO2 émis ;

– 17h00 de fonctionnement d’une ampoule LED ;

– 1h00 de fonctionnement d’une vidéo en ligne.

À titre d’exemple, il a fallu 2048 GPU A100 pour entraîner en février 2023 pendant 23 jours le modèle d’IA générative LLaMA 1 propulsé par le géant du web Meta.

Les modèles déployés à grande échelle, comme ceux utilisés dans des applications comme les assistants vocaux (Siri, Alexa) ou les services de recommandation, nécessitent des ressources de calcul permanentes qui consomment de l’énergie électrique en continu.

À titre de comparaison l’un des fleurons des processeurs GPU, le "NvidiaA100 Tensor Core GPU" utilisé par beaucoup de modèles d’IA génératives, a une puissance brute de calcul d’environ 19,5×1012 OPS ce qui, en terme d’ordre de grandeur, revient à un millième de celle du cerveau humain pour une puissance consommée de 250 W !

Le cerveau humain a une puissance brute de calcul 1000 fois plus grande que celle du meilleur processeur GPU actuel pour une puissance consommée 10 fois plus faible !

Pour reprendre l’exemple des 2048 Nvidia A100 Tensor Core GPU nécessaires, par exemple, pour l’entraînement du modèle LLaMA 1de Meta en 2023, l’écart avec les performances énergétiques d’un cerveau humain devient abyssal. Pour une puissance brute de calcul du même ordre de grandeur que celle du cerveau humain, la puissance consommée par l’IA de Meta est 25 600 fois plus importante ! N’oublions pas également qu’une IA est spécialisée dans un domaine bien précis (générer des textes, des images...) alors que le cerveau humain est par essence multitâche.

Nous sommes donc très loin du mythe du grand remplacement des humains par les IA, tant d’un point de vue des performances, que de la puissance consommée.

Pour exécuter une seule tâche spécialisée (générer un texte, une image...) et pour arriver à une puissance brute de calcul du même ordre de grandeur que celle d’un cerveau humain, la puissance consommée par une IA est environ 25 000 fois plus grande ! Contrairement à une IA générative, le cerveau humain est résolument multitâche et est une merveille d’optimisation énergétique.

Le simulateur en ligne EcoLogits s’appuie sur une bibliothèque Python qui permet de comparer la consommation d’énergie et l’empreinte environnementale liées à l’utilisation des grands modèles de langage d’IA génératives lors de la phase d’inférence par le biais d’API.

Cet outil est développé et maintenu par GenAI Impact, organisation à but non lucratif dédiée à l’évaluation et à la mise en évidence de l’empreinte environnementale des technologies d’IA générative.

Quels sont les principaux facteurs influençant la consommation énergétique des IA génératives ?

L’utilisation de ces sources carbonées entraîne donc des émissions massives de CO2. On estime par exemple que durant sa phase d’entraînement initiale, ChatGPT-3 a émis plus de 500 tonnes d’équivalent CO2. Cela équivaut environ aux émissions de 10 voitures, à moteur thermique, au cours de leur durée de vie. Ces phases d’entraînement peuvent se dérouler plusieurs fois chaque année et elles représentent plus de 90 % de la consommation électrique globale liée au fonctionnement des IA.

En outre, les GPU des serveurs utilisés par l’IA étant très sollicités, ils produisent énormément de chaleur. Cette chaleur est évacuée par un système de refroidissement à eau (watercooling) qui sert de fluide caloporteur. Lors du processus de refroidissement, une partie de l’eau est perdue par évaporation. Un rapport récent de l’université de Californie à Riverside indique [11] que le traitement de 10 à 50 requêtes par les modèles d’IA les plus performants consomme environ 2 L d’eau pour assurer le refroidissement des serveurs. Des entreprises comme Microsoft et Google rapportent une hausse significative (20 à 30 %) de leur consommation d’eau ces deux dernières années, mettant en évidence l’impact environnemental croissant de l’IA.

Vers des IA et des usages plus éco-responsables ?

Face aux défis environnementaux, les géants du web et les fondeurs de GPU dédiés à l’IA telle que la société Nvidia, travaillent conjointement, à la mise en œuvre des technologies du futur, dans les fermes de serveurs, pour réduire drastiquement les rejets de CO2 ainsi que la consommation d’eau et d’électricité. Par exemple, l’industrie des semi-conducteurs s’est engagée depuis plusieurs années dans la production de composants électroniques à faible consommation électrique et émission de chaleur, et ce sans pour autant sacrifier leur performance.

L’implantation géographique des data centers en fonction des conditions climatiques locales (les zones tempérées sont à privilégier) et de l’accès à de l’électricité de proximité d’origine renouvelable (énergie solaire, éolienne, hydroélectrique, géothermique...), doit désormais également être prise en compte.

Enfin, l’optimisation du code des algorithmes permettant de moins dépenser de ressources machines durant la phase d’entrainement des IA génératives, est également une piste sérieuse d’amélioration. En outre, certains développeurs travaillent sur des modèles d’IA embarqués localement sur des smartphones et utilisant exclusivement les ressources machines forcément limitées de ceux-ci. Par exemple, le modèle LlaMa-3-8b est 10 fois plus petit en terme de taille que ChatGPT 3.5 mais est aussi puissant que ce dernier pour certaines tâches spécialisées. Cette voie vers des IA embarquées hyper spécialisées et énergétiquement frugales, semble être prometteuse.

Les quelques recommandations suivantes appliquées aux utilisateurs peuvent contribuer à réduire significativement l’empreinte carbone des IA génératives.

Prioriser les usages à forte valeur ajoutée :

- Utiliser préférentiellement les IA pour effectuer des tâches complexes qui nécessitent réellement leurs capacités avancées.

- Éviter de recourir aux IA génératives pour de simples recherches d’informations qui peuvent être effectuées avec des outils moins énergivores. Un simple moteur de recherche correctement utilisé fera l’affaire dans la plupart des cas !

Optimiser les requêtes :

- Formuler dans un prompt des questions précises et concises pour obtenir des réponses plus ciblées.

- Éviter les conversations prolongées inutiles avec les chatbots IA. Une IA doit rester un simple outil sans que l’utilisateur fasse preuve d’anthropomorphisme.

Éduquer les utilisateurs aux enjeux environnementaux de l’IA :

- S’informer sur l’impact environnemental des IA génératives.

- Partager ses connaissances avec son entourage familial et au sein de son organisation professionnelle.

- Privilégier les fournisseurs d’IA qui s’engagent dans des démarches de réduction de leur empreinte carbone en favorisant les énergies renouvelables.

Cela peut aussi vous intéresser

Intelligence artificielle : évolution ou révolution ?

Créativité et apprentissages : comment intégrer l’IA générative dans sa pédagogie ?

IA générative : l’art du prompt

Comment une IA générative crée-t-elle du texte ?